De la dynamique épidémiologique au Machine Learning

La propagation épidémiologique, particulièrement vigoureuse dans le cas du COVID-19, peut être modélisée par des approches mathématiques – notamment par la modélisation SIRD et SIERD (Lire l’article « Les ressorts d’une dynamique épidémiologique » ) – permettant de quantifier le nombre de cas confirmés ainsi que sa dynamique.

Une approche complémentaire à l’étude de la propagation du virus, ne nécessitant pas de connaitre précisément cette dynamique complexe, est celle consistant à étudier les profils des personnes contaminées et leur gravité. D’un point de vue probabiliste, il s’agit de caractériser des profils avec leur impact covid (hospitalisation légère, réanimation, létalité, etc.) conditionnellement à leur contamination ou hospitalisation.

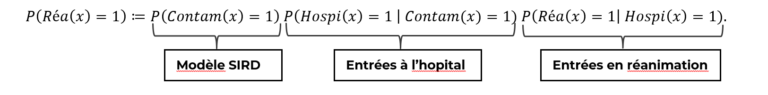

La formule de Bayes nous permet de séparer l’effets de la dynamique de propagation du virus de celui de l’impact d’une personne contaminée et hospitalisée. Par exemple s’agissant de la probabilité qu’un patient entre en réanimation, la décomposition de Bayes nous donne le résultat suivant :

Ainsi, nous notons que le risque d’entrée en réanimation d’un patient quelconque peut se décomposer en trois facteurs, respectivement :

- Son risque d’être contaminé

- Son risque d’être hospitalisé (gravité de premier ordre)

- Son risque d’être en réanimation (gravité de second ordre)

Etant donné que les personnes contaminées ne sont pas toutes hospitalisées et donc suivies, car pas toutes testées, dans cet article nous nous focaliserons sur le troisième terme concernant le risque d’entrer en réanimation des patients hospitalisés.

Ainsi, pour un patient hospitalisé pour raison covid, nous noterons la probabilité cible d’entrée en réanimation étudiée :

En pratique, l’estimation du taux d’hospitalisation pour raison covid dépend fortement de la capacité de test, qui est une problématique à part entière que nous n’évoquerons pas ici et qui est par ailleurs investiguée par notre Taskforce COVID-19.

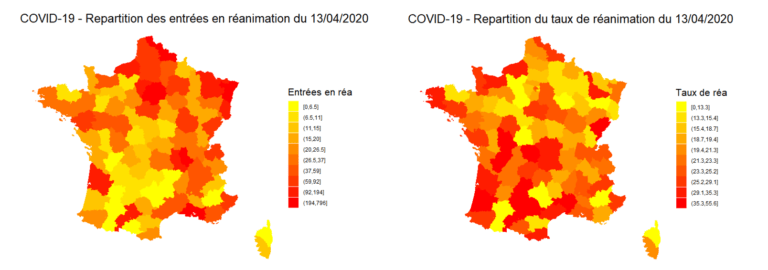

Par ailleurs, l’étude de l’évolution journalière des entrées en réanimation est naturellement très corrélée au nombre d’habitants dans la zone considérée. Notre approche consiste justement à élaguer cette forte dépendance puisque nous étudions un ratio d’entrées en réanimation parmi les hospitalisés. Le nombre d’habitants pourra néanmoins être considéré dans la modélisation.

Nous illustrons ci-dessous la répartition de la réanimation sur le territoire français, en nombre et en proportion d’hospitalisés :

Figure 1: Répartition des entrées et des taux de réanimation au 13/04/2020 par addactis® Detect

Nous pouvons observer une disparité entre le nombre de réanimation d’une part et la proportion de réanimation par hospitalisation d’autre part, synonyme d’une certaine gravité. Une analyse plus détaillée tenant compte de l’évolution en temps des différentes zones du territoire permet de caractériser cette gravité et de la suivre dans le temps, pour chaque département par exemple. Nous présenterons ces analyses temporelles dans un futur article.

La modélisation de la probabilité d’entrer en réanimation des hospitalisés peut se faire au moyen de l’apprentissage statistique avec des algorithmes de Machine Learning, avec un historique de données de patients hospitalisés et de données connexes qu’il faut au préalable construire.

Les données des patients hospitalisés sont cruciales

La recherche médicale est un domaine où les techniques avancées de modélisation statistique et d’apprentissage sont très utilisées, notamment au sein des instituts de recherche (INSERM, Institut Pasteur, etc.). De telles études permettent d’aider au diagnostic de certaines maladies comme le cancer, d’identifier des facteurs de risque, de caractériser le fiabilité d’un traitement, etc.

La finesse et l’exhaustivité des données des patients est donc primordiale pour l’étude de tels effets. Concernant le Covid-19, la communauté médicale scientifique partage des données au niveau international afin que chaque pays ou région puisse alimenter leurs modélisations en tenant compte de leurs propres caractéristiques.

De telles données de santé avec un tel niveau de précision ne peuvent évidemment pas être diffusées au grand public. Plusieurs plateformes data à travers le monde proposent des données agrégées par territoire, c’est notamment le cas en France via le portail data.gouv qui reprend les données de Santé Publique France à une maille départementale.

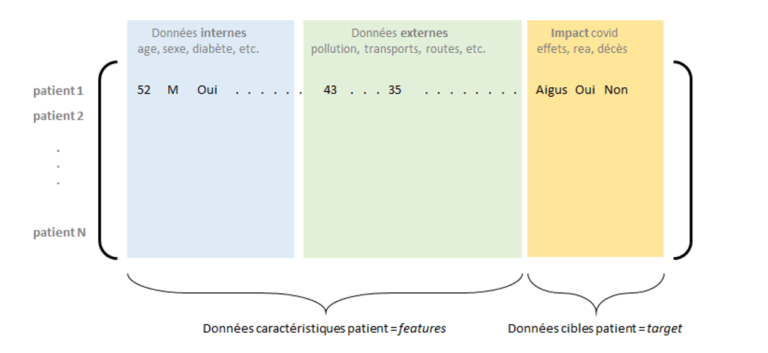

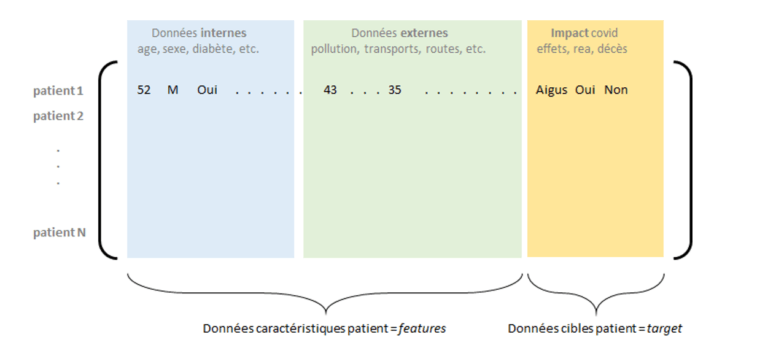

La contextualisation des données patients – les données externes

Un autre enjeu avant les étapes de modélisation est celui de la contextualisation des données des patients, ou encore la complétion d’information pouvant contribuer à l’explication d’entrée en réanimation par exemple. Parmi ces données informatives, nous retrouvons bien sûr les caractéristiques nominales des patients (âge, sexe, IMC, etc.), mais aussi les facteurs de comorbidités (diabète, hypertension, etc.) – dont il sera alors possible de quantifier l’impact. Par ailleurs, il est également pertinent de s’intéresser à des facteurs « externes », notamment liés à la zone géographique où réside le patient ou à ses activités : pollution, nombre d’établissement ou de lits médicaux présents dans sa zone, infrastructure routière (facilité d’accès au soin), mode de transport, etc.

Ce travail de contextualisation nécessite une première partie d’identification des indicateurs, et une deuxième partie de collecte et d’agrégation avec la base de données des patients.

Il convient de préciser que l’ensemble de ces données varient au cours du temps, à mesure de l’évolution sanitaire due à cette épidémie, ce qui accroit certes l’information disponible au temps t, mais l’intégration de cette dimension temporelle dans les modèles nécessite des approches spécifiques qui feront l’objet d’un futur article. Nous nous focalisons donc sur la situation sanitaire à un temps donné.

Figure 2 : Matrice de données internes et externes consolidées, avec les impacts covid pour un ensemble de patients

La constitution et la consolidation d’une base de données suffisamment exhaustive et fiable permet la construction de modèles de Machine Learning pour l’apprentissage d’une variable cible liée à l’impact du virus sur un patient (probabilité d’entrée en réanimation, de gravité, de létalité, etc.).

Vers l’Apprentissage Statistique

( * les illustrations présentées dans cet article proviennent de données open data et réalisées par des simulations d’addactis® Detect )

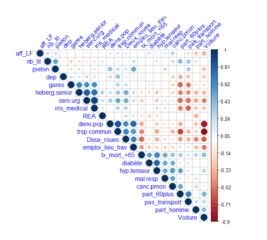

L’analyse descriptive et des corrélations des données consolidées est une étape préliminaire à la modélisation

Figure 3 : Analyse des corrélations des données de l’étude par addactis® Detect

Nous constatons notamment une relation significative des comorbidités (hypertension, maladie respiratoire, diabète) sur l’entrée en réanimation des hospitalisés.

L’apprentissage statistique permet de segmenter la population des patients et d’identifier les facteurs de risques (internes ou externes au patient), et également de construire des modèles explicatifs et prédictifs de la probabilité d’entrée en réanimation par exemple.

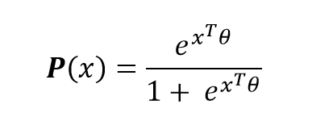

Plusieurs modélisations peuvent être employées : Régression logit, Random Forest, CART, etc. Nous ne détaillerons pas ici toutes ces approches mais nous en présenterons deux : une approche dite paramétrique – celle de la régression logistique (logit) permettant de modéliser la probabilité d’entrée en réanimation d’un patient hospitalisé, et une approche non-paramétrique – par arbre de classification binaire CART.

Notons le vecteur patient d’un individu (non nécessairement présent dans la base de données initiale) qui rassemble l’ensemble des caractéristiques de ce dernier demandées dans la base de données.

Figure 4: Prédiction de l’impact covid d’un nouveau patient hospitalise

La modélisation logit consiste à considérer la forme paramétrique de la probabilité d’entrée en réanimation d’un patient hospitalisé suivante :

où le vecteur de paramètres sera à estimer à partir des données initiales (Maximum de Vraisemblance, etc.). Ainsi, pour un patient hospitalisé quelconque, nous disposons de sa probabilité (ou de son score) d’entrée en réanimation. L’exploitation des paramètres permet de quantifier les effets de chacun de ces paramètres sur ce risque d’entrée en réanimation.

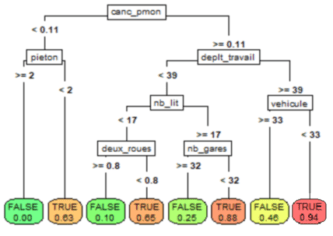

La méthode CART ne fait quant à elle aucune hypothèse sur le modèle ou les données, c’est le principe des méthodes non-paramétriques où les données « parlent d’elles-mêmes ». Cette méthode dispose également de l’avantage d’être très interprétable du fait de l’analyse graphique de l’arbre appris à partir des données – le modèle n’est plus seulement une formule mais un graphe :

Figure 5 : Arbre CART de classification des entrées en réanimation par addactis® Detect

Néanmoins, les arbres de régression et de classification peuvent montrer des limites en termes de robustesse qu’il faudra considérer avec précaution (on pourra alors construire des modèles plus robustes).

Sur un tel arbre, nous pouvons ainsi lire directement les probabilités d’entrées en réanimation en bas des arbres (les feuilles terminales), mais surtout remonter sur les caractéristiques menant à un tel risque (on parlera de profil). Par exemple, l’arbre ci-dessus nous indique qu’un patient ayant eu un cancer ou des problèmes graves du poumon et se déplaçant fréquemment sans faire usage de son véhicule, a un très fort risque d’entrée en réanimation. Nous pouvons également constater que l’activité piétonne diminue le risque d’entrée en réanimation.

Il est possible d’explorer plus en détail l’arbre en augmentant sa profondeur, ce qui fera notamment apparaitre d’autres comorbidités comme le diabète et l’hypertension, ainsi que des facteurs externes comme l’usage des transports en commun, etc.

Conclusion

Nous avons présenté dans cet article une démarche complémentaire à la modélisation épidémiologique du Covid-19, qui consiste à se baser sur une exhaustivité d’information liée aux patients et à leur environnement pour modéliser l’impact de ce virus. Cette approche data nécessite d’une part l’accès aux données fines des patients hospitalisés, et d’autre part de données de contexte qu’il faut au préalable identifier et collecter. Nous avons mentionné quelques-unes de ces données externes, et nous pouvons également citer les données liées au confinement, aux mesures prises par chaque préfecture, etc. Néanmoins, il convient de veiller à ce que la quantité d’information collectée ne soit pas trop grande afin d’éviter le « fléau » de la dimension bien connu en Machine Learning. Une étape de réduction de dimension est très souvent nécessaire, nous avons eu recours à ces techniques-ci pour cette étude.

Nous avons distingué l’« effet de masse » des entrées en réanimation de certains départements (dû en grande partie à leur densité de population) de l’ « effet de gravité » d’une hospitalisation pour cause covid-19. Nous avons pu observer que la proportion d’entrée en réanimation des hospitalisés sur une zone ne suivait pas nécessairement l’évolution du nombre d’entrées en réanimation absolu.

La prise en compte de l’évolution dans le temps des données est importante pour la compréhension de la dynamique de l’épidémie, même dans un contexte Machine Learning qui classiquement se réfère à des données statiques.

Nous présenterons dans un prochain article comment les Modèles de Machine Learning peuvent illustrer, et parfois expliquer, la dynamique de l’épidémie.

Nabil RACHDI, Head of Data Science